Как работают поисковые системы. Факторы ранжирования

Оглавление:

- Поиск и индексирование новых сайтов и документов

- Поиск ответов на запрос пользователя и отображение результатов выдачи

- Факторы ранжирования

Основная задача поисковых систем (ПС) – дать максимально четкий, полный, правильный и удовлетворяющий ответ на запрос пользователя.

Для этого Google и Яндекс непрерывно ищут, обрабатывают и предоставляют в выдаче документы. А затем анализируют поведение пользователя: как он реагирует на выдачу, какие ссылки открывает, как долго находится на той или иной странице – чтобы сформировать алгоритмы, на основе которых поисковики и будут функционировать дальше.

Поисковые системы умнеют, совершенствуя принцип своей работы, чтобы понимать, что именно размещено на сайте и как это может удовлетворить поисковую потребность пользователя.

Мы будем говорить о поисковых системах Google и Яндекс, потому что на их долю приходится обработка подавляющего большинства всех запросов пользователей. Так, по данным Яндекс.Радар, представленность рынка поисковых систем в Беларуси на 2022 год составляет:

- 70,20% Google

- 29,02 % Яндекс

- 0,59 % Mail.ru

- 0,02 % Rambler

Суть SEO оптимизации состоит в том, чтобы сделать содержимое сайта видимым для поисковых систем, обеспечить беспрепятственный сбор данных с важных страниц сайта. Затем эта информация попадет в базу данных Google и Яндекс. И далее поисковики, проранжировав данные разных сайтов, сформируют выдачу и покажут пользователю подборку сайтов, включая продвигаемый сайт.

SEO специалисту важно понимать, как работают поисковые системы, чтобы взаимодействовать с сайтом и поисковиками на всех этапах, обеспечивать бесперебойную работу сайта и поднимать его в выдаче за счет оптимизации внешних и внутренних факторов.

Алгоритм работы поисковых систем состоит из следующих этапов:

- поиск новых сайтов и документов

- сканирование и индексирование страниц сайтов

- поиск ответов на запрос пользователя

- ранжирование найденных документов

- отображение результатов выдачи, ее кеширование

- анализ результатов выдачи

- тестирование новых алгоритмов работы

Рассмотрим, как работают поисковые системы, подробнее.

Поиск и индексирование новых сайтов и документов

Вначале роботы поисковых систем выходит из «дома» - поисковой системы и отправляется бороздить просторы интернета, чтобы найти новые документы и сайты. Поисковый робот ходит по разным страницам сайта и собирает с них работоспособные ссылки, а затем «утаскивает» их обратно «домой», в поисковую систему. Позже по этим ссылкам пройдет другой робот, который соберет со страниц информацию, обработает ее специфическим образом и занесет в базу данных поисковой системы – то есть, проиндексирует ее.

- Процесс работы первого робота-маршрутизатора – сканирование: обход страниц сайта и сбор ссылок, которые работают, то есть ведут на существующие страницы с информацией.

- Процесс работы второго поискового робота называется индексирование – занесение информации сайта в индекс поисковых систем, добавление ее в базу данных.

Как поисковая система вообще узнает о том, что появились новые сайты или документы? Способов несколько:

- когда пользователь открывает сайт или документ через браузеры поисковых систем - Google Chrome, Яндекс.Браузер

- когда пользователь открывает сайт или документ через панель инструментов Google Toolbar или Яндекс.Бар с других браузеров

- когда пользователь переходит на страницу сайта, где установлена система статистики Google Analytics или Яндекс.Метрика

- когда вебмастера "приглашают" поискового робота обойти сайт или новые страницы, добавляя их в Яндекс.Вебмастер и Google Search Console.

- когда сайт становится популярным и количество ссылок на него растет.

Вот почему задача SEO-специалиста на данном этапе – помочь поисковым роботам «увидеть» непопулярный сайт. Для этого создается карта сайта Sitemap.XML, добавляются внутренние и внешние ссылки, регулярно обновляется контент.

Важно: с момента, когда поисковый робот занес информацию в базу данных Google и Яндекс, поисковые системы знают конкретную страницу именно в таком виде, как им ее показали. При поиске ответа на запрос пользователя поисковик будет обращаться не на сайт напрямую, а в свою собранную базу данных. И если с момента обхода роботами сайта страница изменилась, эти изменения поисковик учитывать не будет – пока не произойдет апдейт (обновление) самих ПС. То есть пока робот снова не обойдет страницу и не соберет уже измененную информацию.

- в Google апдейт происходит ежедневно

- в Яндекс – 2-3 раза в неделю.

Процесс обращения поисковых роботов к новым сайтам и страницам и извлечения из них информации (текстов, изображений, видео) называется краулингом. Этот процесс имеет ограничения, которые называются краулинговым бюджетом.

Суть в том, что если на сайте сотни и тысячи страниц, как бывает с интернет-магазинами и сайтами-агрегаторами, или ресурс неизвестный и на него ведут немногие ссылки, робот не будет за один визит сканировать и заносить в индекс все страницы. Лимит страниц, которые сканирует и заносит в индекс робот за один раз – это и есть краулинговый бюджет.

Соответственно чем он больше, тем быстрее все страницы сайта будут занесены в индекс, появятся в выдаче и начнут приводить трафик – пользователей на сайт.

Заставить робота быстрее краулить сайт невозможно, но можно ему помочь. Чем более популярен сайт и чем актуальнее контент на нем, тем быстрее будет происходить его индексация. Поэтому посещаемость ресурса и наличие ссылок на страницы влияют на краулинговый бюджет. Правда, то, что сайт быстро проиндексируется, совсем не означает высокие позиции в выдаче. Краулинг больших сайтов может затягиваться на несколько недель.

Важно: SEO-специалист может ограничить индексирование сайта или отдельных его страниц, прописав с помощью специального синтаксиса инструкцию для поисковых роботов в особом файле - robots.txt в корневой папке сайта.

Поиск ответов на запрос пользователя и отображение результатов выдачи

Пользователь вводит свой запрос (интент), например, взять в аренду микроавтобус в Минске

И поисковые системы начинают искать ответ на интент. Причем каждый раз обращаться к своим базам данных у Google и Яндекс нет необходимости: поисковики запоминают (кэшируют) результаты выдачи по тому или иному запросу. Происходит это достаточно часто: почти каждую минуту в Google и раз-два в неделю в Яндекс. Кэширование выдачи дает поисковикам возможность быстро ответить практически на любой вопрос.

При отображении ответов на запрос действует принцип персонализации, то есть выдача формируется по результатам предыдущих запросов пользователя и посещаемых им сайтов с конкретного ip-адреса.

Google и Яндекс научились определять демографические данные своих пользователей - пол, возраст, страну и город проживания. К этим данным поисковики подтягивают историю бронирования, отметки на картах, социальные связи из социальных сетей и многие другие данные, которые собираются даже в режиме отключения настроек персонализации или в приватном режиме. Даже если пользователь посещает сайты с разных устройств - ноутбука и самартфона, например, но использует для авторизации свой аккаунт, поисковые системы собирают и запоминают эти данные, объединяя их в общую картину интересов пользователя.

В результате поисковые системы знают о своих пользователях достаточно, чтобы предлагать им ответы на запрос с учетом географии, хобби и интересов. И для двух разных пользователей выдача по одинаковому запросу может сильно отличаться. Так, по запросу «Ява» поисковик предложит статьи про язык Java пользователю, которого «опознает» как программиста, остров, если решит, что пользователь - активный турист или мотоцикл, если пользователь интересуется мотоциклами и техникой.

Важно: при поиске ответа на запрос Google и Яндекс не используют его формулировку дословно, а переформулирует его "в уме", добавляя синонимы или связанные по смыслу термины, чтобы найти максимально полные ответы на запрос пользователя - это называется переколдовка запроса. Для SEO-специалиста важно учитывать переколдовку запроса, добавлять синонимы и связанные термины в заголовки документов сайта, чтобы те показывались по большому количеству запросов.

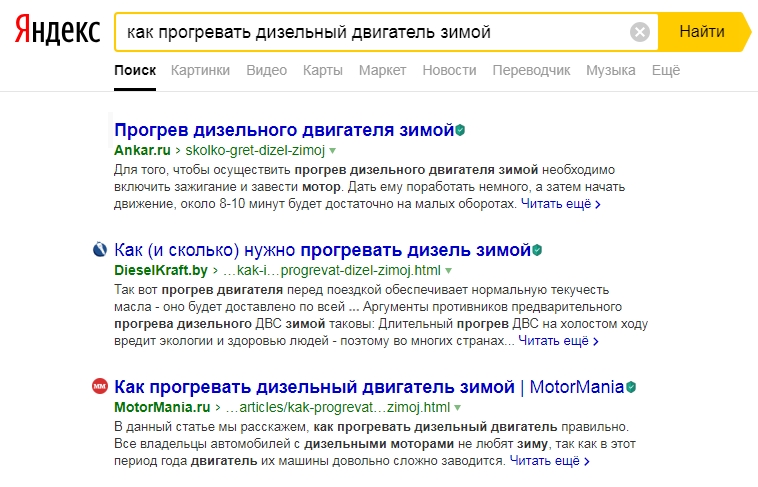

В результате по запросу как прогревать дизельный двигатель зимой выдача может выглядеть так:

После того, как Google и Яндекс отобразили ответы на запрос пользователя, они анализируют качество выдачи. Это позволяет совершенствовать поисковые алгоритмы и предлагать пользователю более качественные ответы.

Качество выдачи поисковые системы рассчитывают так:

- метрики качества + поведенческие метрики + оценки асессоров.

Метрика качества – это, например, основной параметр Яндекса pFound, который высчитывает полезность выдачи на основе двух переменных: вероятность просмотра и релевантность (соответствие пользовательскому запросу) документа.

Поведенческие метрики оценивают реакции пользователей на выдачу: на какие сайты заходят, долго ли задерживаются, возвращаются обратно к поиску или нет. Это такие параметры как общая кликабельность выдачи (если пользователь кликнул первый результат - выдача качественная), время до первого клика, наличие переформулировок (если пользователь уточняет запрос, выдача считается некачественной).

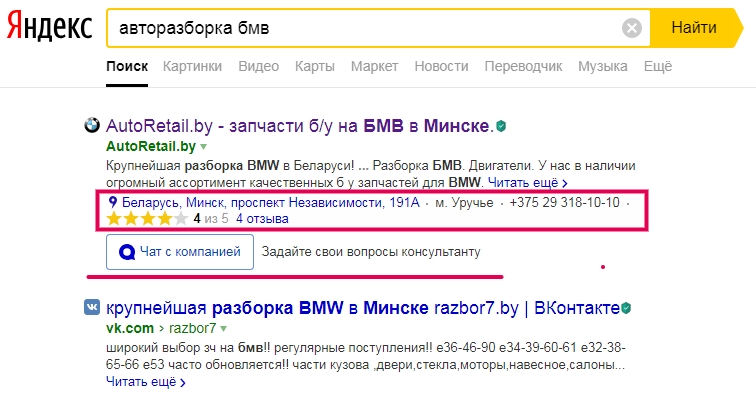

Важно: Меняя элементы сниппета, можно поднять сайт в выдаче, привлечь внимание пользователей и повысить кликабельность документа.

Оценки ассессоров - людей, которые помогают поисковым системам обрабатывать запросы. Только у Яндекса более полутора тысяч таких модераторов. Асессоры совершают поисковый алгоритм, проверяют выдачу и ставят метки, которые в том числе повлияют на ранжирование сайтов в выдаче. Ассесоры оценивают актуальность и пользу материала, присваивают сайтам оценки, вроде «Useful» или «Irrelevant», отмечают спам и контент 18+. Проверяют ассортимент товаров, удобство поиска и пользования корзиной на коммерческих сайтах, достоверность сертификатов и контактных данных.

Важное направление работы поисковых систем - непрерывное изменение подходов к оценке полезности сайтов пользователям, смена алгоритмов ранжирования, тестирование различных алгоритмов.

Google и Яндекс пытаются детально выявить смысл запроса пользователя и сопоставить его со всем текстом документа. Так действует, например, алгоритм «Королев» в Яндексе.

Активно развиваются антиспам-алгоритмы, появляются новые фильтры, которые борются с «чрезмерной оптимизацией» и понижают в выдаче сайты, не несущие полезной и актуальной информации для пользователя - вроде «Баден-Баден», «Минусинск», «Пингвин», «АГС», «Панда», «Переспам». Причем тестирование алгоритмов влияет на выдачу: результат выдачи для коллег по офису, которые сидят в интернете с разных устройств, может быть разным по одному запросу - просто потому, что один из пользователей попал в фокус-группу тестирования.

Важно: с введением новых алгоритмов поисковиками ничего сделать нельзя, кроме как быстро к ним адаптироваться, повысив требования к наполнению и структуре сайта. Поэтому SEO специалист постоянно вынужден вносить доработки на сайт, корректировать страницы и их наполнение с учетом изменений алгоритмов Google и Яндекс.

Факторы ранжирования

Когда Google и Яндекс находят документы, которые отвечают на интент, они сортируют (ранжируют) их таким образом, чтобы сверху показать наиболее релевантные – те, которые максимально соответствуют запросу.

Чтобы определить, какие документы окажутся наиболее полезными для пользователя, поисковые системы используют «функцию релевантности», высчитывая числовое значение соответствия документа запросу. Полный вид этой формулы под названием Okapi BM25 - коммерческая тайна поисковиков. Известно лишь, что высчитывается функция релевантности на основе факторов ранжирования.

- Яндекс учитывает более 800 факторов ранжирования

- Google учитывает, как минимум, 271 фактор ранжирования

Пытаться узнать и учесть абсолютно все факторы ранжирования невозможно.

Для SEO специалиста важно иметь представление о наиболее важных факторах и руководствоваться ими как правилами «как должен выглядеть и функционировать сайт, чтобы понравится пользователям». Сайт нравится, полезен пользователю - значит, одобрен поисковой системой, значит, находится выше в выдаче и приводит трафик.

Для SEO специалиста удобно разделять факторы ранжирования по направлениям, каждое из которых стоит оптимизировать. При этом воздействие только на одну группу факторов к успеху не приведет, в оптимизации сайта важен комплексный подход.

Таким образом, получаем факторы ранжирования:

- Внутренние. Возраст сайта, его структура, количество страниц, скорость загрузки, удобство навигации и пользования сайтом. Отсутствие технических ошибок. Свойства контента - всей видимой информации на страницах сайта. Текстовая релевантность - наличие ключевых слов, синонимов и связанных терминов в тексте. Наличие мета-тегов, тегов разметки HTML.

- Внешние. Ссылочный профиль - популярность и авторитетность сайта в сети, количество и качество ссылок с других сайтов. Репутация компании в сети - SERM. Страницы компании и взаимодействие с клиентами в социальных сетях.

- Поведенческие. Посещаемость сайта. Поведение пользователя на этапе выдачи и пользования сайтом: кликабельность сниппета, время, проведенное на сайте, глубина просмотра, реакция на контент. Удобство взаимодействия пользователя с сайтом - юзабилити. Наличие адаптивной верстки, мобильной версии сайта.

- Коммерческие (для интернет-магазинов). Наличие широкого ассортимента с полным описание товаров, конкурентность цен. Страницы контактов, информация о доставке и гарантии. Необходимый функционал - корзина, калькулятор, кнопки заказа. Информация о акциях, новости и статьи, документация.

Важно: суть SEO продвижения сайтов заключается в оптимизации факторов ранжирования. Именно этот фронт работ позволяет поднять сайт в выдаче, привести на него целевой трафик, повысить узнаваемость и лояльность к бренду.